운동하는 공대생

갤럭시 S25 에서 LLM 구동하기 (llama.cpp, Termux) 본문

먼저 개발자 모드로 휴대폰 변경 필수이니 미리 변경하고 실행을 해야 한다.

사전 준비

1. Termux 설치

Termux는 안드로이드에서 리눅스 터미널 환경을 제공하는 앱이으로, 리눅스 명령어 실행, 패키지 설치, 개발 작업 등을 모바일에서 할 수 있다.

https://play.google.com/store/apps/details?id=com.termux&hl=ko

Termux - Google Play 앱

터미널 에뮬레이터 및 리눅스 환경을 제공합니다.

play.google.com

실행

먼저 Termux를 실행하면 아래와 같이 화면이 나온다.

Termux는 unix 기반의 안드로이드 장치에서 리눅스 환경을 제공합니다.

하지만 sudo 같은 관리자 권한은 없고 디바이스에 따라서 다르게 적용됩니다.(최신 사양의 휴대폰은 root 권한이 거의 없음)

$ apt update && apt upgrade -y

$ apt install git cmake

$ git clone https://github.com/ggml-org/llama.cpp.git

$ cd llama.cppllama.cpp 깃허브 참고 링크

llama.cpp build 방식은 링크 참고

모델 추론에 사용되는 gguf 파일은 hugging face에서 다운로드한다.

$ curl -L {model-url} -o ~/{model}.gguf

빌드한 실행 파일 실행

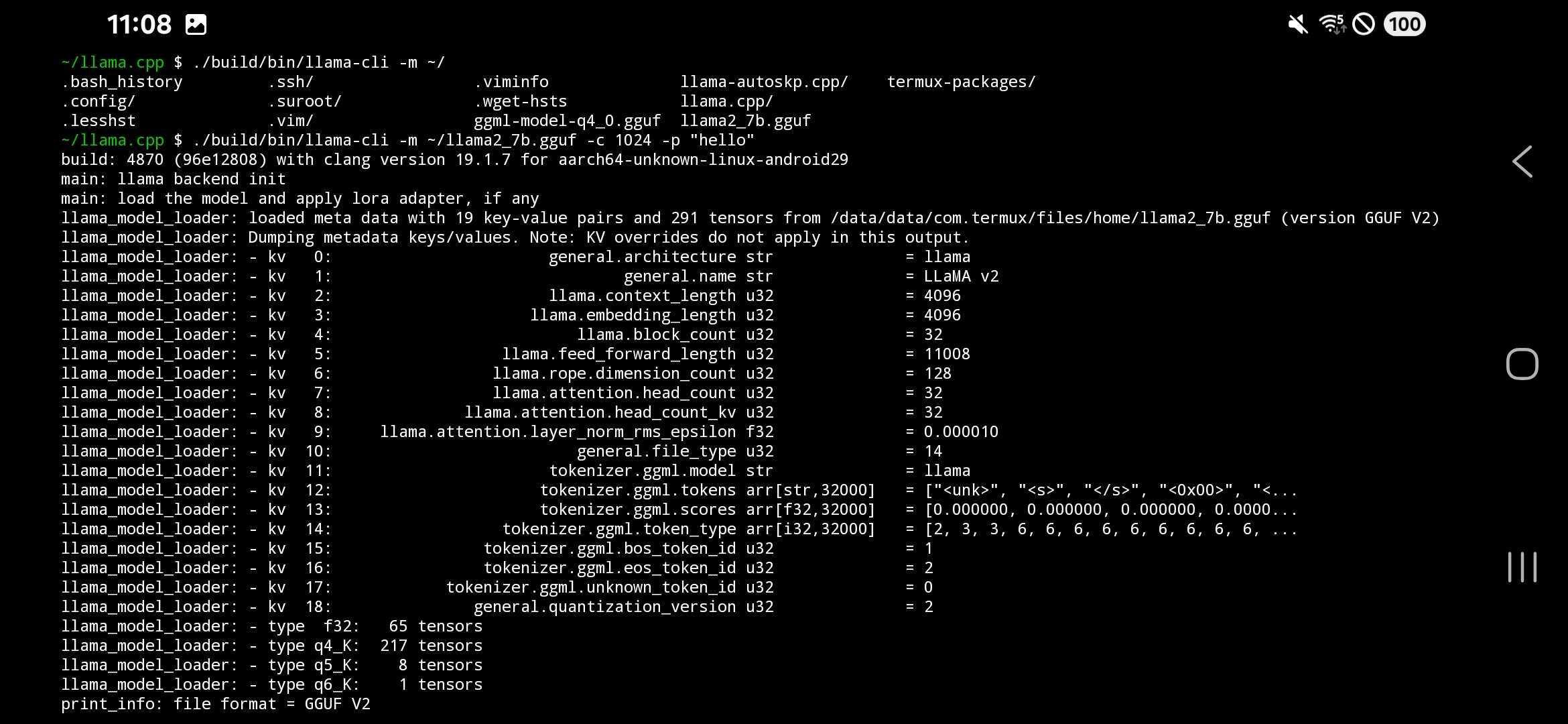

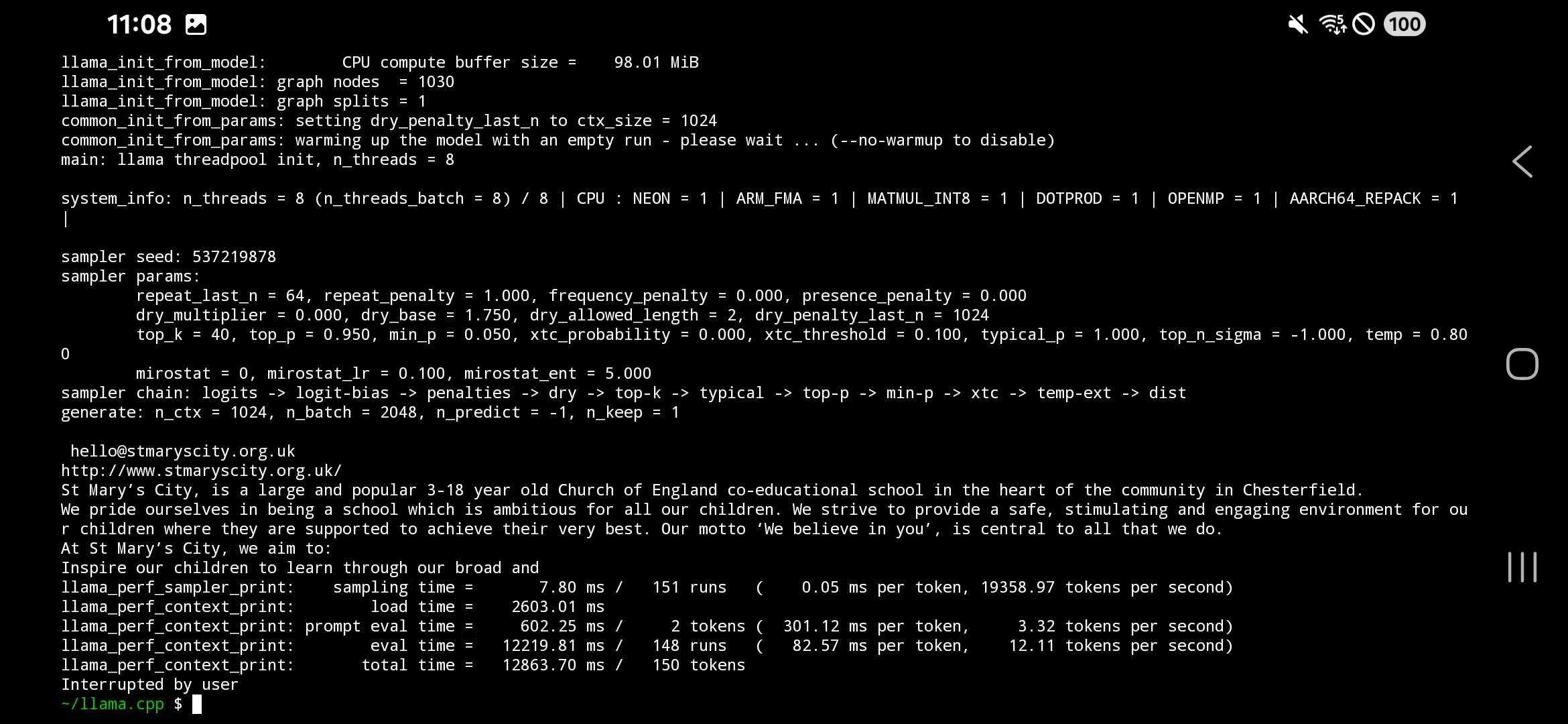

$ ./build/bin/llama-cli -m ~/{model}.gguf -c {context-size} -p "{your-prompt}"

실행 결과

기본적으로 top을 찍어보면 token 생성 시간인 12.11 token/second로 나오지만 퀄컴 스냅드래곤 8 elite 칩셋 버전 기준으로 NPU 사용 시 17.9 token/second를 찍다고 나와있음

https://aihub.qualcomm.com/models/llama_v2_7b_chat_quantized?domain=Generative+AI

Llama-v2-7B-Chat

State-of-the-art large language model useful on a variety of language understanding and generation tasks.

aihub.qualcomm.com

'Deep Learning' 카테고리의 다른 글

| [Deep Learning]Quantization (양자화) (1) | 2025.01.02 |

|---|---|

| [Deep Learning] GCN - Graph Convolution Network (0) | 2023.07.04 |

| [Deep Learning] CNN-Convolutional Neural Networks (1) | 2023.04.27 |

| [Deep Learning] 다층 퍼셉트론 이론과 역전파 (0) | 2022.12.15 |

| Deep Learning(딥러닝) (0) | 2022.11.17 |