운동하는 공대생

[Deep Learning] 다층 퍼셉트론 이론과 역전파 본문

https://seungwoni.tistory.com/30

Deep Learning(딥러닝)

Intro 머신러닝 분야를 공부를 시작하면서 자연스럽게 접하게 되었던 딥러닝 분야 공부를 항상 미뤄왔다가 이번 여러 대회를 참가하면서 비정형 데이터들의 분류와 예측하는 대회들이 유행하고

seungwoni.tistory.com

단층 퍼셉트론

그림 1. 에서 퍼셉트론의 구조를 간단하게 표현을 해놨다.

이런 퍼셉트론의 구조 때문에 단순한 선형 데이터들은 구분이 가능하다 논리 회로의 OR, AND는 구분이 가능하지만 XOR 같은 연산은 하기가 어렵다. 그래서 이런 퍼셉트론의 한계를 보안하고자 다층 퍼셉트론 이론이 등장하게 되었다.

다층 퍼셉트론

단층 퍼셉트론에서 XOR 연산을 하지 못해서 생기는 문제를 다층 구조의 퍼셉트론으로 해결을 하면서 이 이론이 활성화가 되기 시작했다.

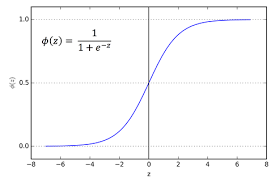

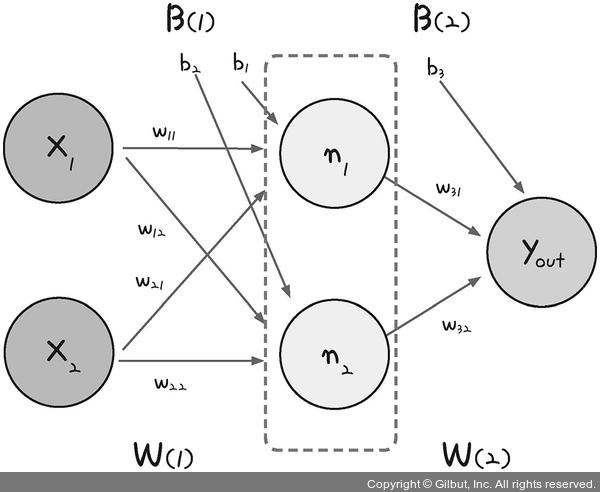

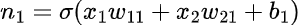

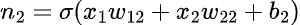

그림 3 에서 처럼 노드와 1개의 입력층과 1개의 은닉층으로 구성되어있는 다층 퍼셉트론을 예를 들어 설명을 하겠다. 입력층 노드(x1, x2)는 은닉층 노드(n1, n2)에 가중치 w를 두고 연결이 되어있다. 그리고 은닉층은 시그모이드 함수(σ)를 이용해 최종 값으로 결과를 보냅니다.

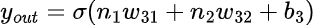

이 과정을 식으로 나타내면 아래와 같다.

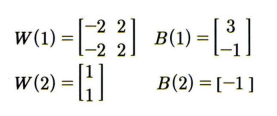

이제 간단한 숫자를 대입하여 어떻게 작동하는지를 설명을 하겠다.

먼저 각각의 층의 가중치(w)와 임계치(b) 를 배열의 형태로 각각 지정을 해주어야 한다.

두번째 입력값으로 설명을 해보겠다.

- x1=0 ,x2=1 을 입력값으로 n1 노드에 값을 입력하면 각각 [0,1] 과 [-2 , -2]t 행렬을 곱하고 각각의 임계치를 더하여 시그모이드 함수를 적용한다. 그러면 n1 값은 1이 된다.

- 그리고 위와 같은 방식으로 n2 값을 구하면 n2는 1이 된다.

- 마지막으로 출력층의 값을 n1, n2 의 값을 입력값으로 하여 같은 방식으로 결과를 내면 최종적으로 값을 1이된다.

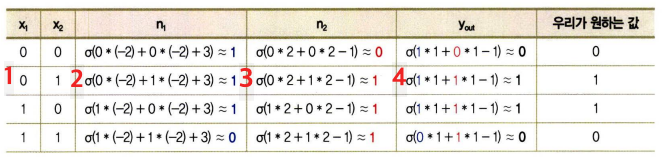

역전파

이렇게 다층 퍼셉트론이 등장하고 XOR 문제를 해결하면서 이를 이용한 인공지능 모델이 많이 각광을 받았다. 하지만 여기서 다층 구조에서도 한 가지 문제가 있었다 그것은 모델을 구성하고 층을 구성할 때 위의 방식처럼 학습을 해 나가면서 가중치와 임계치를 구하는 방식을 '순 전파(Forward Propagation)'이라고 한다. 그리고 순 전파에 따라 결정된 값을 최적화를 하기 위해서는 가중치(W)와 임계치(b)를 조정을 해주어야 한다. 이때 등장하는 개념이 '역전파' 이론이다.

역전파(Back Propagation)은 순 전파를 진행하면서 생기는 실제값과 예측값의 오차를 활용하여서 역으로 노드를 탐색하여 가중치를 업데이트하는 방식이다. 이렇게 반복을 하다 보면 모델의 신경망의 노드를 최적화하는 게 가능하다.

'Deep Learning' 카테고리의 다른 글

| [Deep Learning] GCN - Graph Convolution Network (0) | 2023.07.04 |

|---|---|

| [Deep Learning] CNN-Convolutional Neural Networks (1) | 2023.04.27 |

| Deep Learning(딥러닝) (0) | 2022.11.17 |

| GAN(Generative Adversarial Networks)(3/3) (0) | 2022.10.21 |

| GAN(Generative Adversarial Networks)(2/3) (0) | 2022.10.18 |