목록지피티 (2)

운동하는 공대생

[논문]LORA: LOW-RANK ADAPTATION OF LARGE LANGUAGE MODELS

[논문]LORA: LOW-RANK ADAPTATION OF LARGE LANGUAGE MODELS

논문https://arxiv.org/abs/2106.09685 LoRA: Low-Rank Adaptation of Large Language ModelsAn important paradigm of natural language processing consists of large-scale pre-training on general domain data and adaptation to particular tasks or domains. As we pre-train larger models, full fine-tuning, which retrains all model parameters, becomes learxiv.org 1. Introduction Language 모델을 활용하는 다양한 분야에서 특정 ..

[논문] Improving Language Understanding by Generative Pre-Training - GPT-1

[논문] Improving Language Understanding by Generative Pre-Training - GPT-1

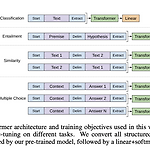

논문 https://www.cs.ubc.ca/~amuham01/LING530/papers/radford2018improving.pdf 1. Introduction 저자는 unsupervised 학습에 대한 어려움을 이야기를 했다. 그게 두 가지가 있는데 최적화를 어떻게 해야 하는지 문제와 데스크마다 변환하는 최적의 방식이 다르다는 문제가 있다. 그래서 이 논문에서는 semi-supervised 방식을 사용하여 이 문제를 해결했다고 말한다. 저자는 semi-supervised와 supervised fine-tuning을 결합하여 사용한다고 말했다. 두 가지의 단계로 훈련을 진행했는데 unlabeled 데이터에 대한 파라미터를 선행 학습하고 그 이후에는 이 파라미터를 가지고 추가적인 supervised 한 ..